Weekly-220403

本文最后更新于:April 3, 2022 pm

本周学习汇报

InstaFormer: Instance-Aware Image-to-Image Translation with Transformer[1]CLIP-GEN: Language-Free Training of a Text-to-Image Generator with CLIP[2]

1. InstraFormer

动机:

在I2IT领域,很多任务仅仅是在做图像层面的转化,而忽略了具体的一些实例,因此就出现了对instance-aware I2I的研究,也就是对图片中的某一个具体的物体进行风格转换,此时就需要考虑图像层面和实例层面的一致性,即高效地整合全局与局部的信息。论文提出了一个新的单向网络,引入ViT,以达到高分辨率的图像与图像之间风格的转换。

应用:

风格迁移、超分辨率、图像修复、图像着色等等。

框架:

单向的端到端的网络,因此可以不使用循环一致损失。

训练方法:

包括了对抗损失(判断最终生成的图像是否足够像目标域中的图像)、Global Content Loss(判断x到y的内容损失)、Instance-level Content Loss(对实例中的内容损失进行考量)Image Reconstruction Loss.(期待生成器可以很好的重构出图像)、Style Reconstruction Loss(更好地对解构的信息进行表达)。

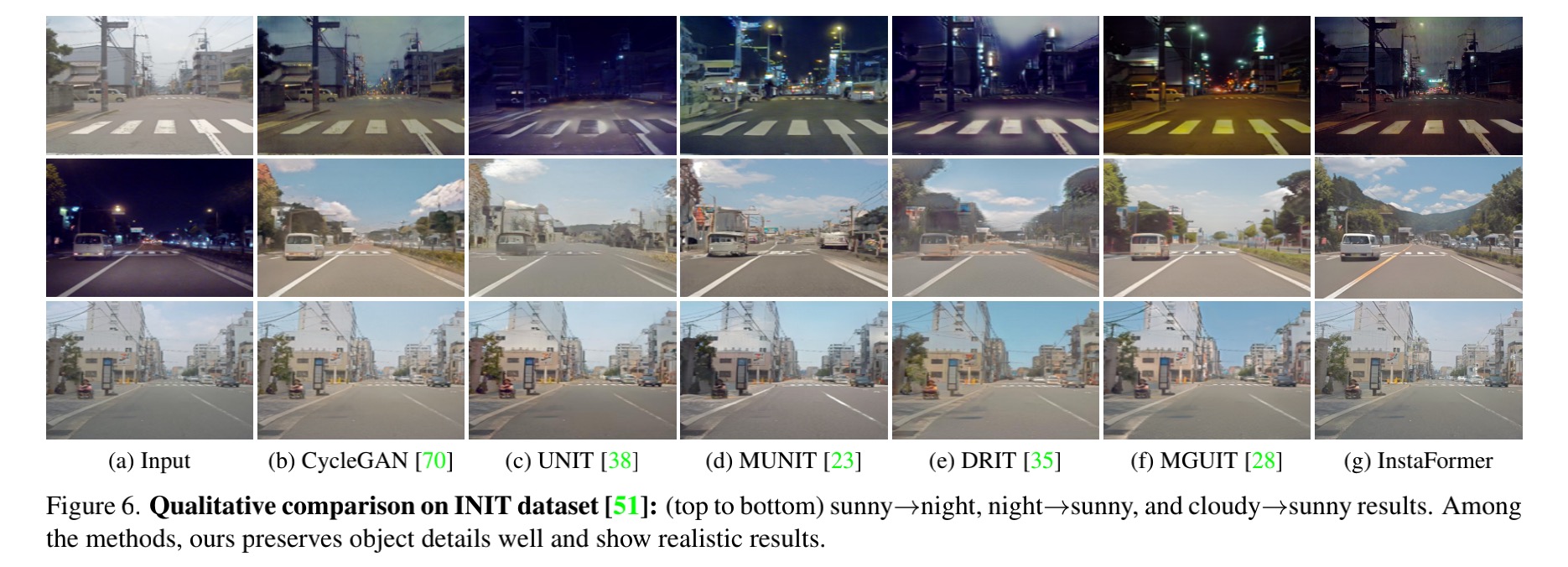

效果对比

2. CLIP-GEN

动机:

训练实现文本图像生成过程中需要大量的文本-图像配对数据,但往往这类数据的获取十分昂贵。本文考虑使用CLIP的Encoder的部分,提取一个图像的embedding,使其在一个联合图像和文本的embedding space中,第二部则采用VQGAN中的codebook将图像转换成一连串的离散的token序列,最后,训练一个自回归的Transformer,来匹配图像的token序列。

框架:

- 包含:CLIP、VQGAN、Condition Transformer等。

- 训练方法:分为两个阶段,其中第一个阶段是对VQGAN的codebook的学习,第二个阶段是对Transformer和CLIP的学习。

应用

- Text-to-Image

效果对比

3. 下一步计划

- 查阅GiTHub上的相关代码。

- 继续阅读相关论文。